© Felix Noak

© Felix Noak

Aravind Battaje

© Felix Noak

© Felix Noak

| Sekretariat | MAR 5-1 |

|---|---|

| Raum | MAR 5.065 |

| Sprechstunden | Nur nach Vereinbarung |

Forschungsinteressen

Wie können biologische Lebewesen in der realen Welt so geschickt manövrieren und interagieren, während von uns geschaffene synthetische Lebewesen außerhalb strukturierter Umgebungen so unbeholfen sind? Eine der Schlüsselfragen ist unser grundlegendes Verständnis der Grenzen (wenn überhaupt) zwischen sensomotorischen Prozessen und der Außenwelt. In meiner Arbeit stelle ich einige dieser Grenzen in Frage. Ich habe zum Beispiel herausgefunden, dass das Betrachten eines Objekts während der Bewegung (Fixieren) einen hohen Nutzen bei Aufgaben hat, die das Suchen und Holen von Objekten beinhalten. Hier sind Wahrnehmung und Handlung (wie traditionell definiert) eng miteinander verbunden. Einerseits ist es wichtig, Grenzen zu erkennen.

Andererseits ist es wichtig, diese als Verhalten ausdrücken zu können und über einen rechnerischen Rahmen zu verfügen, der eine kohärente Verarbeitung von Informationen über die Zeit ermöglicht. Aus diesem Grund bin ich auch daran interessiert, die Prinzipien zu verstehen, die einer robusten Informationsverarbeitung für Wahrnehmungs- und Handlungsströme zugrunde liegen. Zurzeit analysieren wir visuelle Phänomene beim Menschen und erstellen gleichzeitig Computermodelle. Wir iterieren schnell durch Analyse und Synthese (von Modellen) visueller Phänomene, um die Merkmale eines robusten Informationsverarbeitungssystems für Wahrnehmung und Handlung zu definieren.

Kurzlebenslauf

Okt 2019 - heute

Doktorand, TU Berlin

Aug 2017 - Mai 2019

Master of Science, Georgia Institute of Technology- Sep 2013 - Jul 2017

Senior Engineer (Computer Vision), Robert Bosch Sep 2009 - Mai 2013

Bachelor of Engineering, Siddaganga Institute of Technology

Persönliche Webseite: https://oxidification.com/

Publikationen

2023

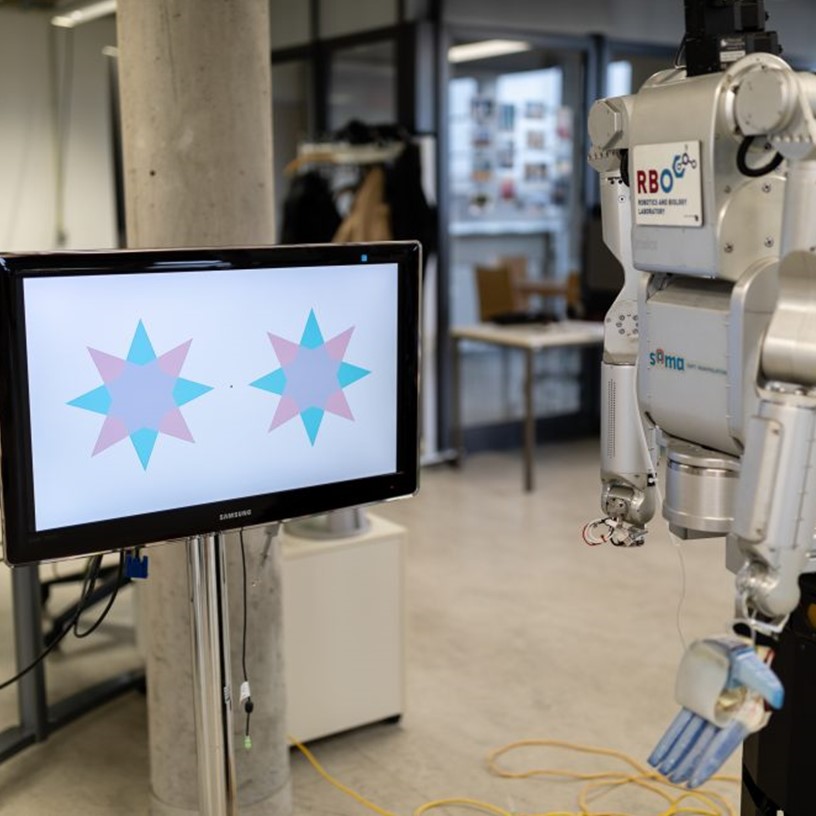

An interactive motion perception tool for kindergarteners (and vision scientists)

i-Perception, 14 (2) :20416695231159182

März 2023

ISSN: 2041-6695

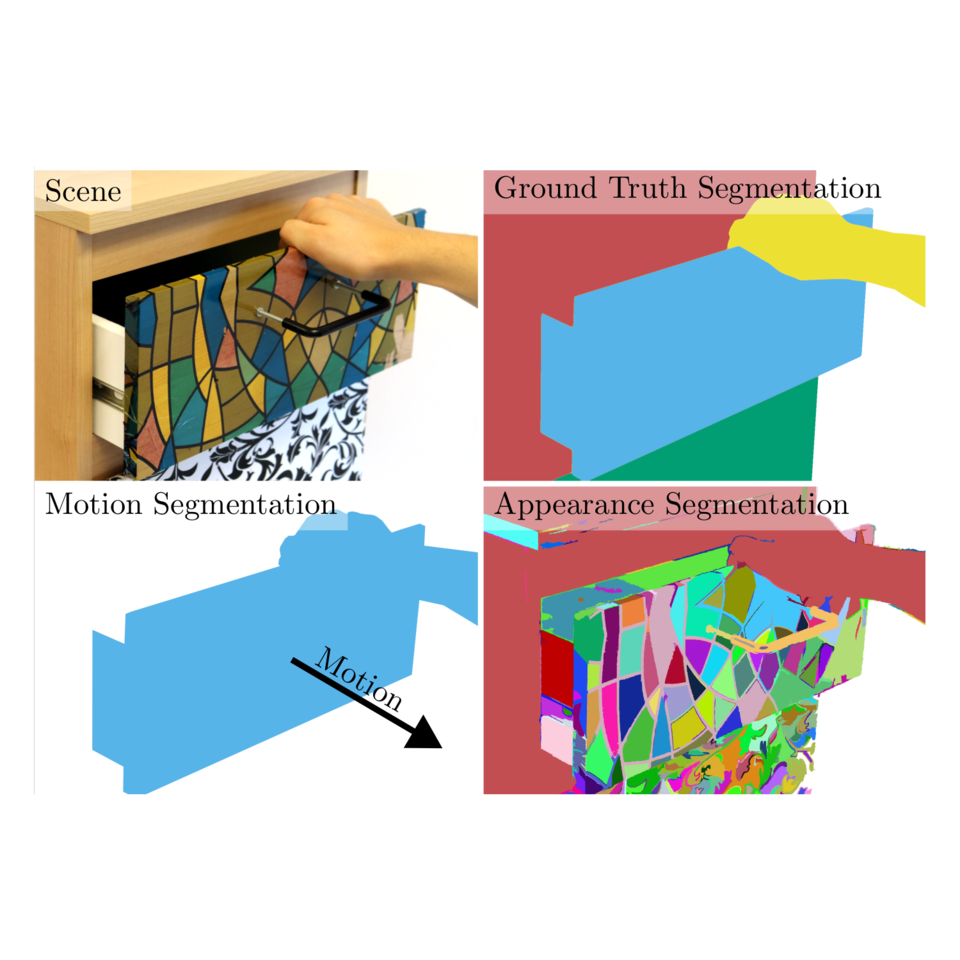

Combining Motion and Appearance for Robust Probabilistic Object Segmentation in Real Time

2023 IEEE International Conference on Robotics and Automation (ICRA), Seite 683--689

IEEE

2023

Estimating the Motion of Drawers From Sound

2023 International Conference on Robotics and Automation (ICRA)

IEEE

2023

2022

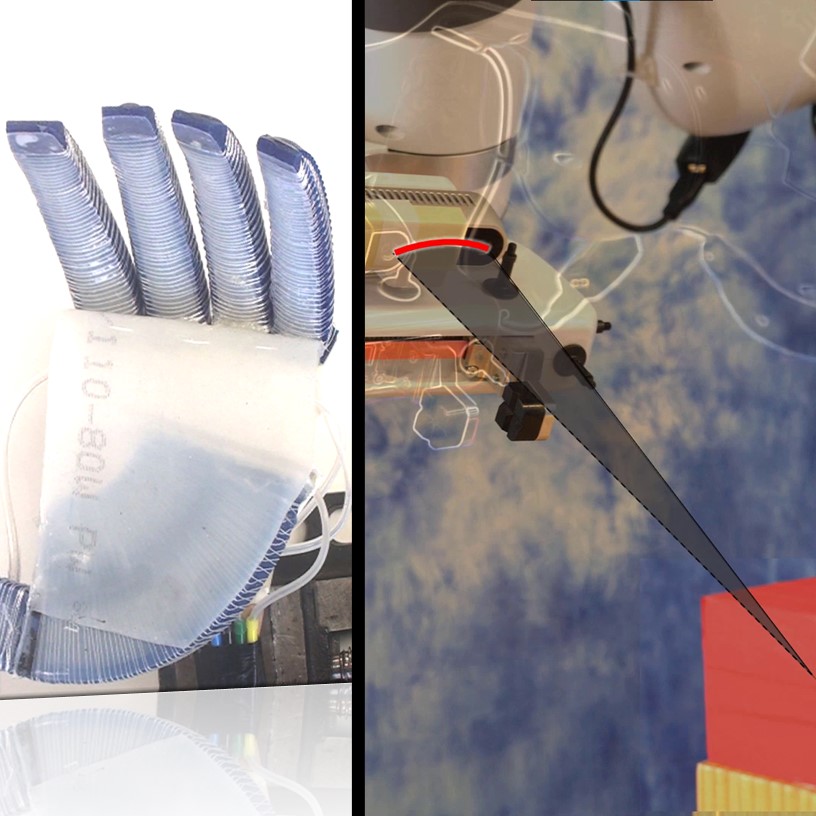

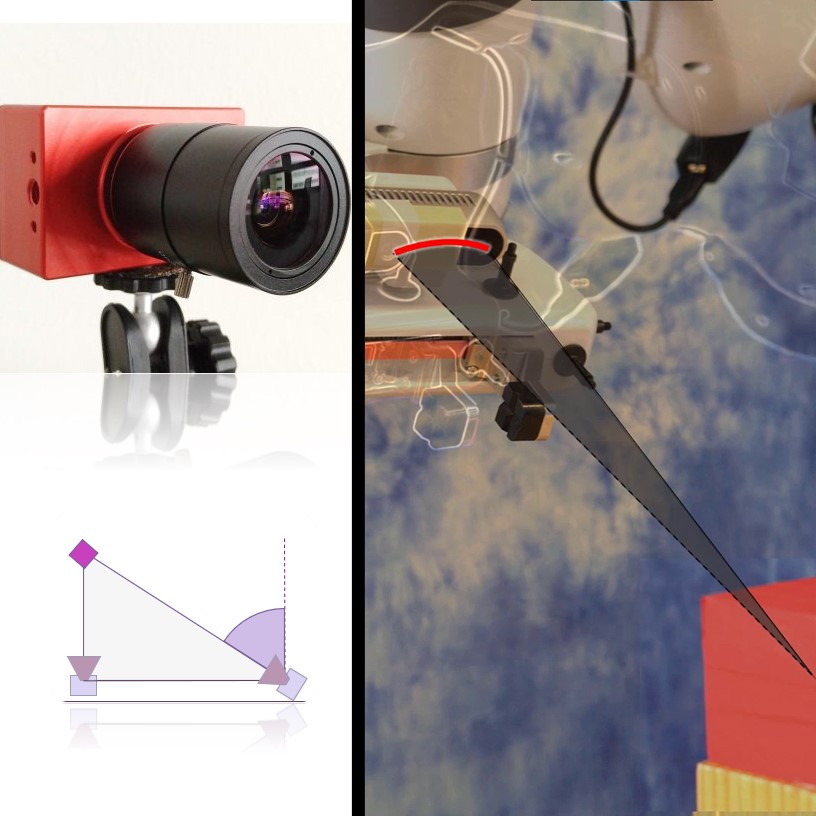

One Object at a Time: Accurate and Robust Structure From Motion for Robots

Proceedings of IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS)

2022

2021

Interconnected Recursive Filters in Artificial and Biological Vision

Proceedings of the DGR Days, Seite 32-32

2021

© RBO

© RBO

© RBO

© RBO